¿Cómo tiene que ser una inteligencia artificial coherente con la Justicia Global? Desde el grupo de trabajo de IA-BCN, formado por diferentes entidades y colectivos de base de Barcelona y coordinado por Lafede.cat, la Federació d’Organitzacions per la Justícia Global, han lanzado una encuesta para hacer un pequeño diagnóstico sobre la intersección entre implementación de sistemas de inteligencia artificial, derechos humanos y Justicia Global. hablamos con Judith Membrives, responsable de digitalización de Lafede.cat

¿Cómo nace el grupo de trabajo y cómo surge la idea de hacer esta encuesta dirigida a entidades, colectivos y comunidades de base?

El grupo surgió hacia octubre, en el marco de la nueva línea de incidencia de Lafede.cat, que se centra en todo lo que es la digitalización, pero desde una vertiente de la automatización de la sociedad y de la inteligencia artificial. Inicialmente, lo impulsó Espai Societat Oberta, pero a partir de enero cogimos el relevo desde Lafede.cat. Para formarlo, nos pusimos en contacto con diferentes personas del ecosistema activista que creíamos que podía ser interesante que estuvieran: que pertenecen a colectivos afectados y entidades y organizaciones relacionadas con la justicia global, y también académicos y grupos de investigación con una visión más sociotécnica. Nos inspiramos en un proyecto de una universidad del Reino Unido, que buscaba incidir en las políticas de la automatización desde la misma comunidad de defensoras de desigualdades y desde varios actores de la sociedad civil.

Al principio se intentó que el grupo funcionara de forma orgánica, pero vimos que íbamos demasiado lentas en comparación, por ejemplo, con la legislación. Todo está cogiendo un gran impulso y si queremos hablar con administraciones y políticos, tenemos que tener claro cuál es nuestro posicionamiento en relación a la inteligencia artificial y la automatización. Por eso, estuvimos trabajando de acuerdo con un par de informes que ha hecho el instituto de derechos humanos de Cataluña donde identifica los riesgos de la implementación de las tecnologías. A partir de estos estudios, y del conocimiento que ya teníamos dentro del grupo motor, elaboramos la encuesta para entender cuáles son las prioridades y los ámbitos que más preocupan para, a partir de aquí, desarrollar un posicionamiento y elaborar un argumentario.

En cuanto a legislación, precisamente este año se tenía que aprobar una directiva de inteligencia artificial en Europa. ¿En qué punto está?

No hay fechas oficiales, pero me atrevería a decir que saldrá entre el primero y segundo semestre del año que viene. Hace poco que se ha producido un cambio de mandato en la presidencia rotatoria del Consejo de la Unión Europea, que ahora ha asumido la República Checa, y se han puesto en contacto con todos los gobiernos estatales para conocer su posicionamiento sobre cuatro aspectos pendientes que se tienen que acabar de negociar. Todo el corpus ya está escrito, pero es una negociación que busca, por un lado, equilibrar la necesidad de promover el crecimiento económico y la innovación, pero, también, proteger los derechos fundamentales de las personas, dicen. No es sencillo.

Al ver que la directiva de la UE no entrará en vigor hasta el 2024, España ha lanzado un plan piloto para que las empresas que desarrollan inteligencia artificial puedan empezar a trabajar. La idea es que, cuando se apruebe, no se pierda tiempo. No es una directiva, es una prueba piloto, la regulación que habrá asociada a ella será la europea.

¿Son coherentes con la justicia global y los derechos humanos?

La posición de Lafede.cat es que tanto la regulación de inteligencia artificial que se está debatiendo en Europa como el planteamiento de prueba piloto español no incluyen suficiente perspectiva de defensa de derechos humanos y justicia global. Se habla siempre desde una óptica europea centrista, no se tiene en cuenta, por ejemplo, todo el impacto que puede tener a escala ambiental el desarrollo de la IA en países del sur global. Además, no se está teniendo en cuenta a la sociedad civil organizada y todavía menos a las organizaciones que defienden la justicia global. Todavía queda camino por recorrer para introducir la perspectiva de defensa de derechos humanos y la cocreación participativa desde las organizaciones.

Por otro lado, quería hacerte la misma pregunta que vehicula la encuesta. ¿Cómo tiene que ser la inteligencia artificial para ser coherente con la justicia global y con los derechos humanos? ¿Es posible que lo sea?

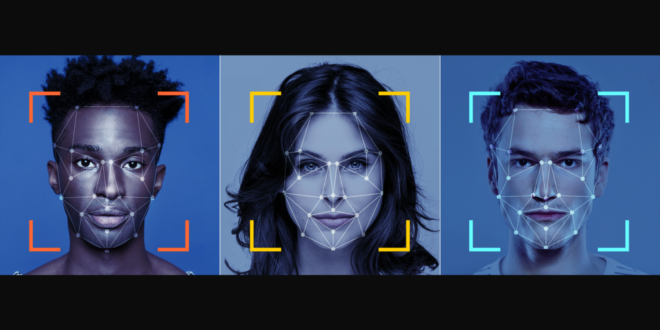

Creo que lo primero que nos tenemos que preguntar cuándo estamos ante un proyecto que puede introducir inteligencia artificial o una automatización es: ¿Qué puede pasar si esto lo automatizo de una manera en que no hay ninguna persona humana haciendo seguimiento?. Para mí, más allá de los sesgos o de los problemas que conocemos que puede haber relacionados con la IA o los sistemas algorítmicos, el principal es la asimetría de poder. Es decir, que yo, como comunidad afectada en el momento de tomar esta decisión de que se automatizará un proceso, ya esté en una condición de inferioridad. Además, seguramente, se verá agraviada por una condición previa de inferioridad o de discriminación.

No sé si es posible una inteligencia artificial justa. Toda la ideología que hay alrededor de la innovación y del progreso, no tiene prácticamente nunca en cuenta las comunidades afectadas. Y dentro de estas comunidades, estoy pensando también en agentes no humanos, en dificultades que surgen, por ejemplo, en la naturaleza por culpa de la contaminación que provocan las nuevas tecnologías. Dudo que la ideología que hay alrededor de la innovación sea compatible con una inteligencia artificial que no vulnere derechos y que sea coherente con los valores de la justicia global. Esto no quiere decir que niegue la innovación. No estoy diciendo que no se tenga que innovar, pero quizás nos tenemos que plantear hacer las cosas más lentamente, con algo más de reflexión previa y conjunta y generando más interdependencia entre todos los agentes que pueden estar implicados en un proceso de automatización.

La sensación es que el Covid lo ha acelerado y, además, las grandes empresas de software o apps han ampliado su monopolio.

El problema más grande es que la infraestructura necesaria para poder construir el sistema de IA y de aprendizaje automático, por ejemplo, lo tienen muy pocas empresas. Incluso, pequeñas start-ups que son referentes y que están desarrollando tecnología basada en IA están usando una infraestructura que han creado previamente Microsoft, Amazon, Google… Si los ‘andamios’ son de ellos, son los grandes monopolios los que sacan beneficio. No sé si este modelo de innovación actual que depende tanto de partenariados público-privados con grandes empresas tecnológicas es la manera de llegar a una IA con valores más coherentes con la justicia global y los derechos humanos. Tendríamos que hablar otras maneras de desplegar IA utilizando herramientas que nos den autonomía tecnológica.

¿Cómo se puede empoderar las entidades en temas de inteligencia artificial, uso de datos y transformación digital? ¿Qué paso pueden dar?

Como ejemplos, se puede intentar apostar por software de videollamada que no sea un Zoom o un Meet de google, usar Jitsi o Big Blue Bottom, que es más respetuoso con el medio ambiente porque intenta ahorrar ancho de banda. Pero, es muy difícil iniciar todo un proceso de cambio de una entidad en cuanto a las herramientas. Sobre todo porque hay una serie de costumbres, de manera de hacer… y la administración tampoco lo pone fácil. Para poder ir hacia una tecnología más autónoma, tiene que haber una apuesta decidida por parte de la administración porque las entidades solas no podemos competir contra las grandes tecnológicas. En Lafede.cat tenemos un proyecto que se llama PlataformESS, pero si lo quieres escalar a entidades federadas, necesitas recursos y una persona que pueda hacer el mantenimiento necesario. Si no tenemos todo esto, es normal que acabes yendo a buscar una herramienta gratuita que no tengas que pagar y que sepas que funcionará correctamente.

¿Qué oportunidades tienen por delante las entidades con relación a la inteligencia artificial?

Uno de los retos más grandes que tenemos las entidades es entender que esta tecnología está presente en todos los ámbitos. Aunque nos dediquemos a un sector que aparentemente no tiene relación con la tecnología, el uso que le damos y nuestras decisiones al elegir una u otra puede estar afectando ámbitos que ni nos imaginamos.

También, lo que tenemos que reivindicar es que, si nos encontramos que el gran problema de la IA es que no es justa y que tiene este potencial para vulnerar derechos, quién tiene que estar velando para que cumpla ciertos mínimos y estándares son las entidades y activistas defensoras de derechos humanos. Somos un actor clave. Quizás no sabemos de tecnología, pero esto hace mucho tiempo que lo hacemos. Cada vez nos incluyen más en los debates, pero no en los procesos de decisión y no hacerlo es dejar de lado toda nuestra experiencia y conocimiento en defensa de derechos humanos. Cuanto más participemos las entidades o cuanto más traslademos este debate a las organizaciones para que introduzcan estos puntos en su agenda, más oportunidades de incidencia surgirán y más opciones de utilizar estas herramientas en favor nuestro.

¿Qué consejo darías a las entidades sociales?

El primero, que no les tiene que dar miedo acercarse a la tecnología. No tienen que pensar en ella como algo ajeno a lo que no se pueden acercar. No hay que ser tecnólogo para entender cuál es el impacto que tiene la tecnología en la vida de las personas o para identificar ciertos peligros. El segundo que, como entidades y personas que somos, tenemos que ser conscientes que tendremos contradicciones. Vivimos en un sistema que nos obliga a tenerlas: capitalista y dónde hay monopolios y ciertos pensamientos e ideas hegemónicas. Es obvio que no podemos ser puristas: en algunas situaciones, tendremos que decidir qué contradicción queremos aceptar y qué no. No nos tenemos que martirizar por eso. Por otro lado, un error que veo a menudo al intentar hacer una digitalización más coherente es decir: «A partir de hoy, no uso Google, Microsoft…». No es tan sencillo. Se tiene que hacer de forma pautada y consensuada, formarnos y pensar qué ámbitos de nuestros trabajo como entidad se pueden ver afectados por la implementación de algoritmos y de IA desde un acercamiento más holístico.