Com ha de ser una intel·ligència artificial coherent amb la Justícia Global? Des del grup de treball d’IA-BCN, format per diferents entitats i col·lectius de base de Barcelona i coordinat per Lafede.cat, la Federació d’Organitzacions per la Justícia Global, han llençat una enquesta per fer un petit diagnòstic sobre la intersecció entre implementació de sistemes d’intel·ligència artificial, drets humans i Justícia Global. En parlem amb Judith Membrives, responsable de digitalització de Lafede.cat.

Com neix el grup de treball i com sorgeix la idea de fer aquesta enquesta dirigida a entitats, col·lectius i comunitats de base?

El grup va sorgir cap a l’octubre, en el marc de la nova línia d’incidència de Lafede.cat, que se centra en tot el que és la digitalització, però des d’un vessant de l’automatització de la societat i de la intel·ligència artificial. Inicialment, el va impulsar Espai Societat Oberta, però a partir del gener vam agafar el relleu des de Lafede.cat. Per formar-lo, ens vam posar en contacte amb diferents persones de l’ecosistema activista que crèiem que podia ser interessant que hi fossin: que pertanyen a col·lectius afectats i entitats i organitzacions relacionades amb la justícia global, i també acadèmics i grups d’investigació amb una visió més sociotècnica. Ens vam inspirar en un projecte d’una universitat del Regne Unit, que buscava incidir en les polítiques de l’automatització des de la mateixa comunitat de defensores de desigualtats i des de diversos actors de la societat civil.

Al principi es va intentar que el grup funcionés de forma orgànica, però vam veure que anàvem massa lents en comparació, per exemple, amb la legislació. Tot està agafant una gran embranzida i si volem parlar amb administracions i polítics, hem de tenir clar quin és el nostre posicionament amb relació a la intel·ligència artificial i l’automatització. Per això, vam estar treballant d’acord amb un parell d’informes que ha fet l’institut de drets humans de Catalunya on identifica els riscos de la implementació de les tecnologies. A partir d’aquests estudis, i al coneixement que ja teniem dins el grup motor, vam elaborar l’enquesta per entendre quines són les prioritats i els àmbits que més preocupen per, a partir d’aquí, desenvolupar un posicionament i elaborar un argumentari.

Pel que fa a legislació, precisament aquest any s’havia d’aprovar una directiva d’intel·ligència artificial a Europa. En quin punt està?

No hi ha dates oficials, però m’atreviria a dir que sortirà entre el primer i segon semestre de l’any que ve. Fa poc que s’ha produït un canvi de mandat a la presidència rotatòria del Consell de la Unió Europea, que ara ha assumit la República Txeca, i s’han posat en contacte amb tots els governs estatals per conèixer el seu posicionament sobre quatre aspectes pendents que s’han d’acabar de negociar. Tot el corpus gros ja està escrit, però és una negociació que busca, per una banda, equilibrar la necessitat de promoure el creixement econòmic i la innovació, però, també, protegir els drets fonamentals de les persones, diuen. No és senzill.

En veure que la directiva de la UE no entrarà en vigor fins al 2024, Espanya ha llençat un pla pilot perquè les empreses que desenvolupen intel·ligència artificial puguin començar a treballar. La idea és que, quan s’aprovi, no es perdi temps. No és una directiva, és una prova pilot, la regulació que hi haurà associada serà l’europea.

Són coherents amb la justícia global i els drets humans?

La posició de Lafede.cat és que tant la regulació d’intel·ligència artificial que s’està debatent a Europa com el plantejament de prova pilot espanyol no inclouen prou perspectiva de defensa de drets humans i justícia global. S’hi parla sempre des d’una òptica europea centrista, no es té en compte, per exemple, tot l’impacte que pot tenir a escala ambiental el desenvolupament de la IA en països del sud global. A més, no s’està tenint en compte a la societat civil organitzada i encara menys a les organitzacions que defensen la justícia global. Encara queda camí per recórrer per introduir la perspectiva de defensa de drets humans i la cocreació participativa des de les organitzacions.

D’altra banda, volia fer-te aquesta mateixa pregunta que vehicula l’enquesta. Com ha de ser la intel·ligència artificial per ser coherent amb la justícia global i amb els drets humans? És possible que ho sigui?

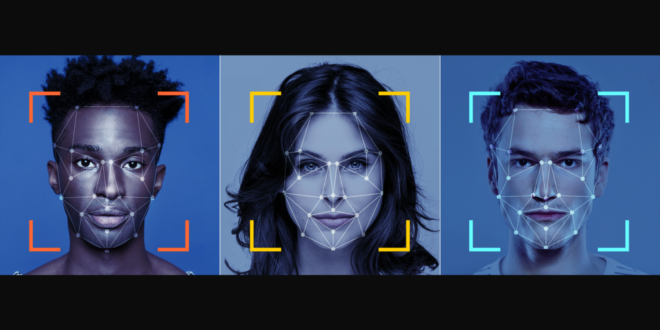

Crec que el primer que ens hem de preguntar quan estem davant d’un projecte que pot introduir intel·ligència artificial o una automatització és, què pot passar si això ho automatitzo d’una manera en què no hi ha cap persona humana fent-ne seguiment? Per mi, més enllà dels biaixos o dels problemes que coneixem que hi pot haver relacionats amb la IA o els sistemes algorítmics, el principal és l’asimetria de poder. És a dir, que jo, com a comunitat afectada en el moment de prendre aquesta decisió de què s’automatitzarà un procés, ja estigui en una condició d’inferioritat. A més, segurament, es veurà agreujada per una condició prèvia d’inferioritat o de discriminació.

No sé si és possible una intel·ligència artificial justa. Tota la ideologia que hi ha al voltant de la innovació i del progrés, no té pràcticament mai en compte les comunitats afectades. I dins d’aquestes comunitats, estic pensant també en agents no humans, en dificultats que sorgeixen, per exemple, a la naturalesa per culpa de la contaminació que provoquen les noves tecnologies. Dubto que la ideologia que hi ha al voltant de la innovació sigui compatible amb una intel·ligència artificial que no vulneri drets i que sigui coherent amb els valors de la justícia global. Això no vol dir que negui la innovació. No estic dient que no s’hagi d’innovar, però potser ens hem de plantejar fer les coses més lentament, amb una mica més de reflexió prèvia i conjunta i generant més interdependència entre tots els agents que poden estar implicats en un procés d’automatització.

La sensació és que la Covid ho ha accelerat tot i que, a més, les grans empreses de programari o apps han ampliat el seu monopoli.

El problema més gros és que la infraestructura necessària per poder construir el sistema d’IA i d’aprenentatge automàtic, per exemple, el tenen molt poques empreses. Fins i tot, petites start-ups que són referents i que estan desenvolupant tecnologia basada en IA estan fent servir una infraestructura que han creat prèviament Microsoft, Amazon, Google… Si les ‘bastides’ són d’ells, són els grans monopolis els que en treuen benefici. No sé si aquest model d’innovació actual que depèn tant de partnerships publicoprivats amb grans empreses tecnològiques és la manera d’arribar a una IA amb valors més coherents amb la justícia global i els drets humans. Hauríem de parlar d’altres maneres de desplegar IA utilitzant eines que ens donin autonomia tecnològica.

Com es pot empoderar les entitats en temes d’intel·ligència artificial, ús de dades i transformació digital? Quines passes poden fer?

Com a exemples, es pot intentar apostar per programari de videotrucada que no sigui un Zoom o un Meet de google, fer servir Jitsi o Big Blue Bottom, que és més respectuós amb el medi ambient perquè intenta estalviar amplada de banda. Però, és molt difícil iniciar tot un procés de canvi d’una entitat pel que fa a les eines. Sobretot perquè hi ha una sèrie de costums, de manera de fer… i l’administració tampoc ho posa fàcil. Per poder anar cap a una tecnologia més autònoma hi ha d’haver una aposta en ferm per part de l’administració perquè les entitats soles no podem competir contra les grans tecnològiques. A Lafede.cat tenim un projecte que es diu PlataformESS, però si ho vols escalar a entitats federades, necessites recursos i una persona que pugui fer el manteniment necessari. Si no tenim tot això, és normal que acabis anant a buscar una eina gratuïta que no hagis de pagar i que sàpigues que funcionarà correctament.

Quines oportunitats tenen per davant les entitats amb relació a la intel·ligència artificial?

Un dels reptes més grossos que tenim les entitats és entendre com aquesta tecnologia està present en tots els àmbits. Encara que ens dediquem a un sector que no sembla que tingui relació amb la tecnologia, l’ús que en fem i les nostres decisions en triar una o altra pot estar afectant àmbits que ni ens ho imaginem.

També, el que hem de reivindicar és que, si ens trobem que el gran problema de la IA és que no és justa i que té aquest potencial per vulnerar drets, qui ha d’estar vetllant perquè compleixi certs mínims i estàndards són les entitats i activistes defensores de drets humans. Som un actor clau. Potser no sabem de tecnologia, però això fa molt de temps que ho fem. Cada vegada ens inclouen més en els debats, però no en els processos de decisió i no fer-ho és deixar de banda tota la nostra expertesa en defensa de drets humans. Quan més participem les entitats o com més traslladem aquest debat a les organitzacions perquè introdueixin aquests punts a la seva agenda, més oportunitats d’incidència sorgiran i més opcions d’utilitzar aquestes eines a favor nostre.

Quin consell donaries a les entitats socials?

El primer, que no les hi ha de fer por acostar-se a la tecnologia. No han de pensar en ella com a quelcom aliè al que no s’hi poden acostar. No cal ser tecnòleg per entendre quin és l’impacte que té la tecnologia en la vida de les persones o per identificar certs perills. El segon que, com a entitats i persones que som, hem de ser conscients que tindrem contradiccions. Vivim en un sistema que ens obliga a tenir-les: capitalista i on hi ha monopolis i certs pensaments i idees hegemòniques. És obvi que no podem ser puristes en tot i que, en algunes situacions, haurem de decidir quina contradicció volem acceptar i quina no. No ens hem de martiritzar per això. D’altra banda, un error que veig sovint en intentar fer una digitalització més coherent és dir, a partir d’avui, no faig servir Google, Microsoft… No és tan senzill. S’ha de fer de forma pautada i consensuada, formar-nos i pensar quins àmbits de la nostra tasca com a entitat es poden veure afectats per la implementació d’algoritmes i d’IA des d’un acostament més holístic.